【摘要】

自从新标准对服务器机柜的进风工作温度范围重新定义之后,数据中心温度管理策略发生了巨大变化,机架或冷通道的进风温度范围扩展到18°C ~27°C,湿度范围扩展到8%-80%。通过提高运行温度,能够提高机房服务器的负载密度。

在相同的负载条件下,提高运行温度也能够大幅削减能源消耗。通过提高机房空调的进风温度,从而使室外低温制冷有更多时间进入数据中心,是实现现代化“绿色”数据中心的关键要素之一。

本文旨在帮助人们了解数据中心的高回风温度设计的必要性,这有助于提高数据中心的冷却方案效率。此外,本文还阐述了提高回风温度所造成的影响、以及如何设计最佳的热管理解决方案。

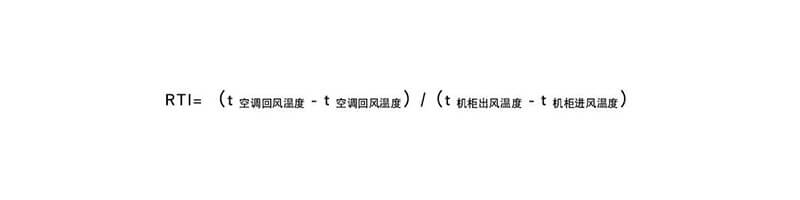

回风温度指数(RTI)[1]

如何分析每个服务器机架应接收多少冷空气才能成功消除数据中心或服务器机房中产生的热量。下列指标利用流体动力学分析中的常规原理来确定数据中心中气流循环的温度性能。

回风温度指数(RTI)表示从冷却机组到机架等设备的输出气流速度。同时,回风温度指数(RTI)还能显示是否存在气流再循环或气流短路现象。

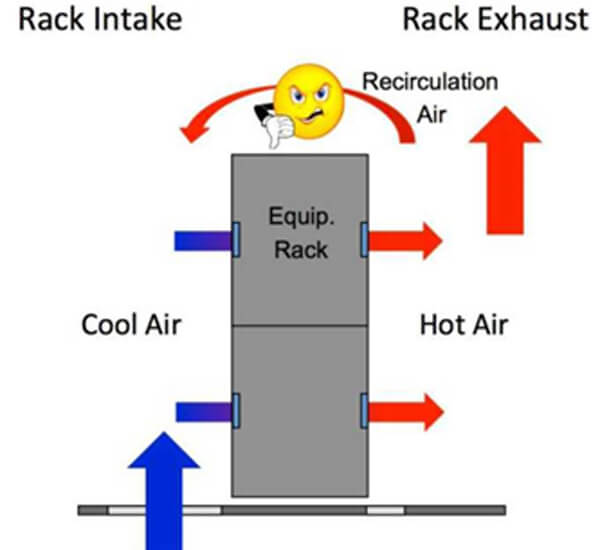

如果回风温度指数大于100%,则表示存在气流再循环现象;如果回风温度指数小于100%,则表示存在气流短路现象。因此,该指数的理想百分比为100%。

理想情况下,优化后的数据中心的回风温度指数(RTI)度量值为100%。然而,这是理论上的。在实际应用中,总会存在一些气流短路和气流再循环现象。关键是要尽量减少这些现象,从而提高数据中心空气处理系统的效率。

图1. 冷却与循环

高精度传感器及智能化软件的综合使用功能可以准确测量计算数据中心的回风温度指数(RTI)、电能使用效率(PUE),识别现有的过冷、过热点及有待改进的机架。

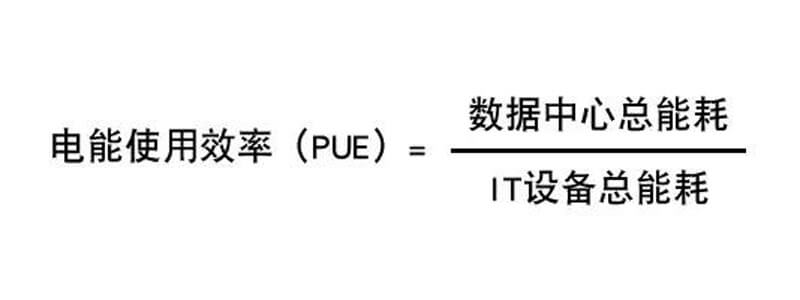

数据中心效率衡量指标(PUE)[2]

电能使用效率(PUE)是指数据中心输入功率与IT负载功率之比。确定数据中心基础设施效率是有效能源管理计划的一部分,其益处已得到广泛认可。

IT基础设施管理者的主要目的是降低基础设施耗电,例如通过减少电力损耗、采用无源基础设施和降低冷却功耗(尤为重要,冷却功耗占数据中心耗电量35%~40%);同时最大限度的提高IT负载率。冷却功耗降低设计还有一个后续措施,即提高机房的温度。我们将在下一节详细讨论。

预计回风温度每上升1°C,数据中心可以节省4%至5%的能源成本。设置较高的温度意味着:自然冷切换工作温度点越高,自然冷时间越长。室外温度由15°C提升到20°C,北京自然冷利用时间增加21.6%,广州增加90%。如果提高到30°C为切换点,北京/上海/广州/深圳城市所跨越的纬度区基本接近90%的时间都可以利用自然冷。

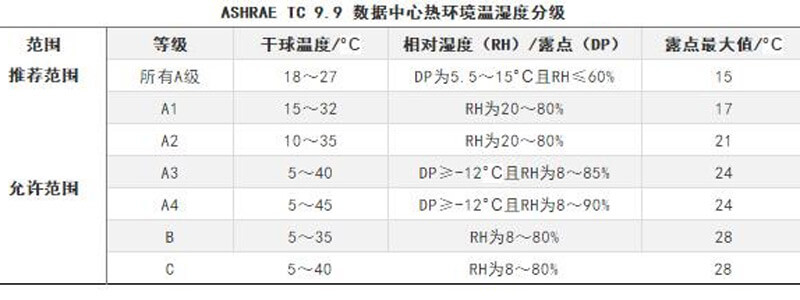

ASHRAE的温度标准指南[3]

ASHRAE推荐的温度范围18°C~27°C,并将A1等级温度提升至32°C是为了支持节能等新技术而创建的。

下表1总结了ASHRAE推荐的温度范围和级别。

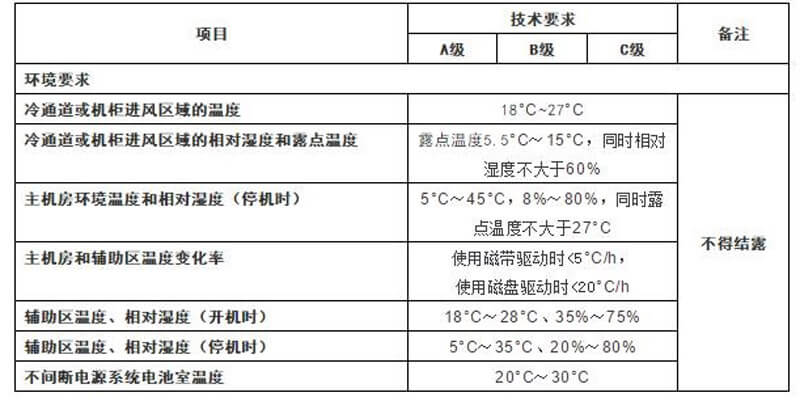

中国的温度标准指南[4]

《GB50174-2017 数据中心设计规范》中,对主机房和辅助区内的温度,露点温度和相对湿度进行定义,考虑到节能的趋势,以冷通道或机柜进风区域的温度为测量认证标准,而且大幅提升到27°C,所以在满足节能,安全应用基础上,按下表2进行:

表2:各级数据中心环境技术要求

数据中心温度管理

业务的不断变化,新政策的推动,正在让数据中心管理者思考如何快速的提高效率,降低数据中心庞大的电量指标。我们将讨论一下关于提升机房回风温度的三个最有争议的问题。

(1)提升回风温度与保持冷/热通道布置

现代服务器比以前的密度更大。这意味着服务器的ΔT(出口-进口)更大。在这种情况下,采用高回风温度是一件很自然的现象。

IT设备的布置(如冷通道或热通道布置)是一般数据中心遵循的最佳实践之一。此配置将IT设备的进气口置于冷通道上(送风侧),并将热空气排放至热通道(回风侧)。目前,很多实践中都允许冷通道温度为24°C,热通道的温度基本上都会更高。

制冷装置的回风温度越高,能够使冷却盘管之间的热交换越好,冷却能力越大,整体效率越高,这几乎对所有的空调设备都有效。一些设备能够处理的最高回风温度可能有限(定频机组<28°C),但一般来说,通过提高回风温度,能够提高所有冷却系统的容量。

在这种情况下,机房空调机组的回风温度较高,这有助于在相同的压缩机电机功耗条件下提高机组的容量。从而提高效率,并为降低PUE增加价值。

(2)提高机组进风温度会使可靠性和设备维护复杂化

提高数据中心温度是提高效率的一部分内容。温度提升必须遵循气流管理的最佳实践:使用密封性能好的通道(RTI≈100%)或消除活动地板下的电缆障碍物,并实施某种形式的气流遏制,这些措施将有效地减少冷热空气的混合。

数据中心采用40°C环境温度是一种极端情况,通过鼓励部分数据中心运营商进行深思熟虑的讨论和批判性研究。研究之后,他们可以将机柜进风温度从20°C提升到24°C,这些变化都可以显著降低Pue,而不影响其可用性或设备保养。

(3)如果数据中心回风温度提高,是否会导致数据中心的维护人员和访客的工作环境不舒适并非所有的数据中心都具有庞大的访客量。一些高性能/超级计算应用程序在无人值守的环境中运行,并包括一组同类硬件,这些应用非常适合较高的温度设定值。

除了让工作人员感到舒适,IT设备的可靠运行也很重要。标准建议将服务器进风温度设定在18°C~27°C之间。通道隔离之后,非控制区的温度可以远远高于27°C;如果是高密度IT设备,非控制区的温度可以远远高于38°C。在GB50736中,考虑到节能与舒适性感觉,长期逗留区域空气计算参数在夏季Ⅱ级热舒适下,温度范围27~28°C,相对湿度40~70%。[5]

所以,人们的期望值需要调整,这样他们才能理解较高的温度是“正常”的,节能的。这种变革需要平衡实际的节能需求与较少时间下人员舒适感的关系。

传统冷却技术的局限性

机房精密空调采用涡旋压缩技术已有30多年的历史,传统普通涡旋技术的主要挑战是在高回风(> 28°C)应用场景中,当回风温度达到设定值时,空调频繁启停机,且无法长期运行恒温环境,导致无冷空气或冷却不足,回风热空气会短路送入冷通道机柜进风侧,超过27°C。

随着“新型变频压缩机”等现代技术的出现,压缩机的蒸发温度提升,密封涡旋电机电枢加强,导致回风温度大大升高,这是数据中心行业更高效设计的进步。

最新节能趋势:使用高回风温度的送风控制逻辑

回风控制策略是否有效需格外关注的两个重要因素:①整个机组入口(回风)区域的温度变化率最小;②从每个机组送入的空气在冷却后返回该机组,形成一个封闭的循环回路。

然而,在所有数据中心中,除了最小和最简单的数据中心外,上述两种情况都不太可能完美存在。即使往最好里说,这也会导致冷却系统效率低下。最坏的情况是,它会导致冷却系统发生热点或停机。

目前数据中心中存在一些常见的因素,如更高的负载密度、负载分布不均匀等,这些因素也导致了更高的温度差。

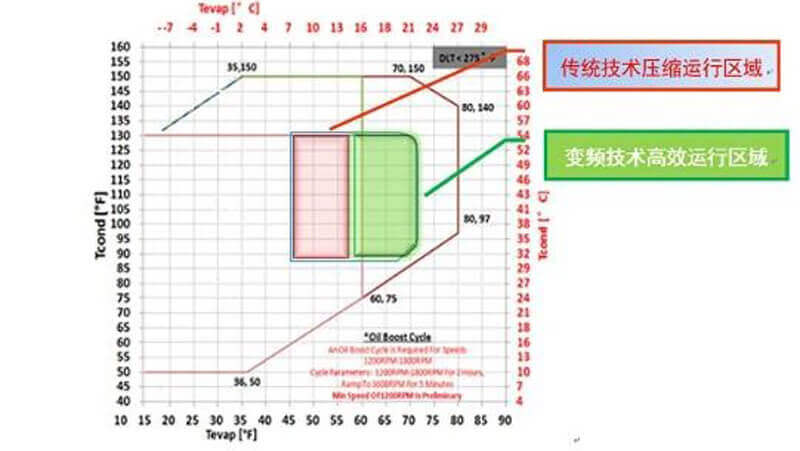

送风温度逻辑被应用于温度控制机制中,智能控制器也在热管理系统中发挥着非常重要的作用。冷却能力取决于风量与ΔT,在IT设备的各种负载中,各个服务器都会产生自身动态的风量和温差。在这种情况下,设置恒定的回风温度并不理想。智能控制器有助于实现冷却能力的动态变化,并保持恒定的压力,从而实现均匀冷却、高效节能。蒸发温度范围越大会导致性能更好,但也会让运行区域变得越复杂。

充分利用变频压缩机技术的高蒸发温度区域,机组运行时同时监控系统低压和压缩机转速,依照动态低压控制逻辑,实现负载变化范围更广,压缩机运行更安全,压缩机运行更高效。

图2 蒸发温度范围越大会导致性能更好,但也会让运行区域变得越复杂。

回风温度每提高一度,冷却能力将提高4%到5%。在RTI接近100%下,通过以上图2变频高效运行范围可知,建议回风温度设定在33°C~40°C之间,房间级冷却设备送风温度保持在21°C~25°C,列间级冷却在22°C~27°C(前提是采用了正确、高效的变频技术精密空调)。

表3:满足设置送风温度范围内的环境参数

结论

基于现场需求,下一代数据中心采用的两个最佳新兴趋势是较高的回风温度和送风控制逻辑。

虽然这两个趋势倡议正在取得进展,用户可以集中精力寻找他们的“最佳平衡点”--设置符合业务需求并且能够提高能效的理想温度值。需要主动测量和分析才能找到“最佳平衡点”,才能够带来降低PUE的最佳实践。

本文作者:

Re-editor:Oliver Yu(Vertiv GC)

Professional Product Manager

original from Dey, Rahul (Vertiv APAC)

【参考文献】

[1] MK Herrlin. [Improved data center energy efficiency and thermal performance by advanced airflow analysis].International Digital Power Forum,2007;10-11

[2] GREEN GRID. [PUE: A COMPREHENSIVE EXAMINATION OF THE METRIC]. 2014

[3] ASHRAE Technical Committee 9.9,2015;14-15

[4] GB50174-2017 数据中心设计规范

[5] GB 50736-2012 民用建筑供暖通风与空气调节设计规范